von André Sebastiani (07.03.2024)

Googles Gemini KI sah sich zuletzt erheblicher Kritik und Spott ausgesetzt. Dazu aufgefordert Bilder von deutschen Soldaten aus dem Jahr 1943 zu generieren, lieferte der integrierte Bildgenerator generierte beispielsweise Darstellungen von einem schwarzen Mann oder einer asiatischen Frau in Uniform.

Die amerikanische Unabhängigkeitserlärung wird auf einem Bild von einer schwarzen Frau unterschrieben, schwarze Päpste oder nicht-weiße Wikinger werden generiert.

Quellen: https://x.com/johnlu0x/status/1760066875583816003?s=20; https://x.com/ReelJustinLewis/status/1761056207681269956?s=20

Die historisch grotesk-falschen Darstellungen haben es inzwischen zu einem eigenen Artikel auf der Satire-Seite The Onion gebracht.

Inzwischen hat Google die Option Darstellungen von Menschen generieren zu lassen wieder entfernt. Der Vorwurf lautet: Googles KI ist „woke“. Der Spott über die übertriebene Political Correctness überdeckt dabei das weit gravierendere dahinterliegende Problem: das sogenannte Alignment Problem (Ausrichtungsproblem) bei Künstlicher Intelligenz (KI).

Gute Absichten führen zu Problemen

Zunächst ist es wichtig, den Kontext von Googles Entscheidungen bei der Entwicklung von Gemini zu verstehen. Der Konzern wollte sicherstellen, dass Bilder von Menschen, die universelle Tätigkeiten ausführen, nicht ausschließlich Weiße darstellen. Die ganze Vielfalt von Googles globaler Nutzerschaft sollte widergespiegelt werden. Dazu musste eine bestehende Schlagseite (Bias) in ihren Datensätzen korrigiert werden: Wenn die Bilder in den Trainingsdaten überwiegend weiße Personen zeigen, werden auch überwiegend weiße Personen generiert. Die ehrenwerten Absichten hinter dem Ziel haben dann dazu geführt, dass das Bias aus den Trainingsdaten überkompensiert wurde und die Personendarstellungen auch da divers ausfallen, wo es im Kontext des Bildes falsch ist.

Das Alignmentproblem

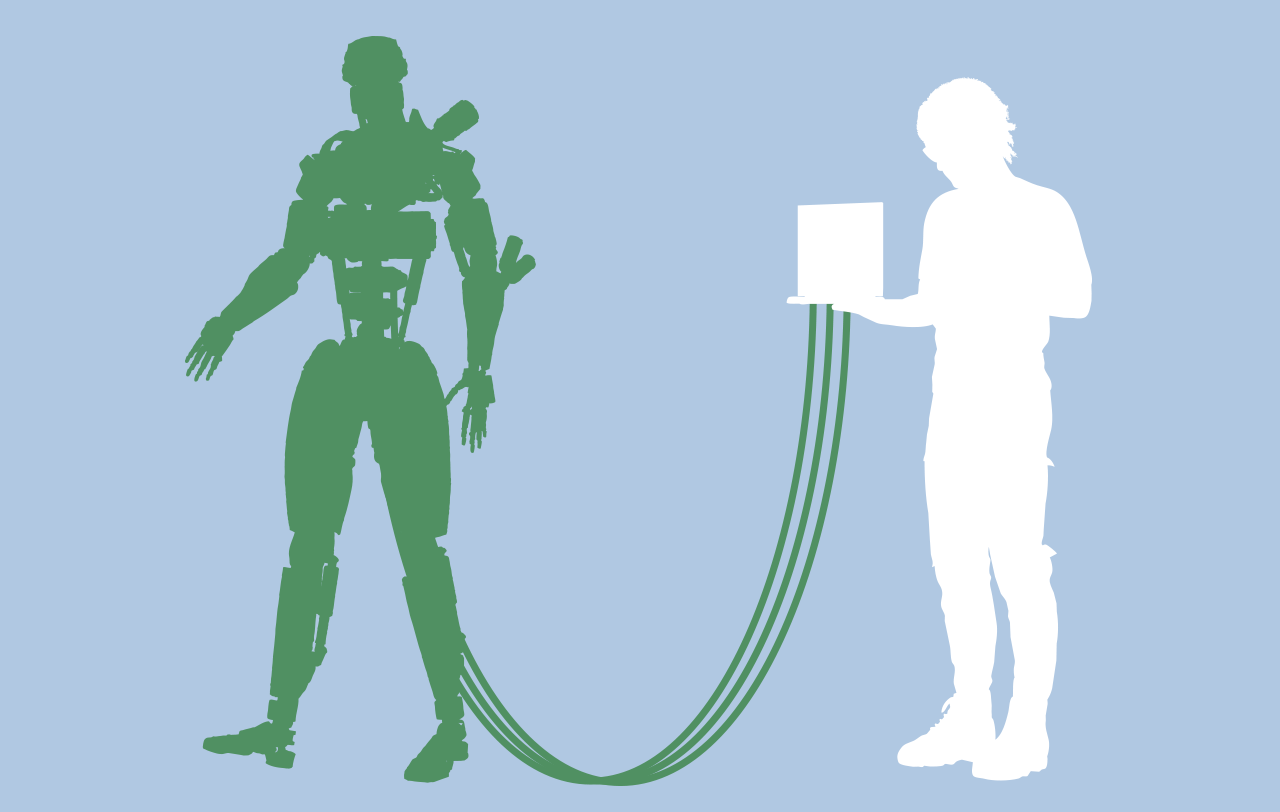

Das Ausrichtungsproblem beschreibt die Herausforderung, Künstliche Intelligenz so zu programmieren, dass sie die ihr gegebenen Anweisungen im Sinne ihrer Schöpfer umsetzt, ohne unerwartete oder unerwünschte Ergebnisse zu produzieren. Die „Woke“-Bilder-Debatte um Gemini wir in diesem Zusammenhang zu einem Symptom eines viel tiefer liegenden Problems.

Ähnlich wie in den Geschichten von Isaac Asimov, in denen Roboter aufgrund ihrer Programmierung unbeabsichtigte Handlungen ausführen, zeigt der Fall von Gemini, dass selbst mit fortschrittlichen Algorithmen und sorgfältiger Planung die Ergebnisse von KI-Systemen oft unvorhersehbar und manchmal auch problematisch sein können.

Ein Problem, das uns alle angeht

Die Implikationen dieses Problems sind weitreichend. Zwar können die Fehler von Gemini noch als kurios angesehen werden. Fehlausrichtungen bei leistungsfähigeren und komplexeren Systemen könnten aber katastrophale Folgen haben. Ist die (hypothetische) Anweisung an eine sehr leistungsfähige KI den Klimawandel zu lösen, könnte diese zu dem richtigen, aber fatalen Schluss kommen, dass eine drastische Reduzierung der menschlichen Bevölkerung die effizienteste Lösung sei. Ähnlich wie bei König Midas, in dessen Händen sich alles zu Gold verwandelte, liegt das Problem manchmal darin, dass man genau das bekommt, was man möchte.

Der Weg nach vorn

Das Alignmentproblem ist nicht nur eine technische Herausforderung, sondern auch eine ethische. Es wirft Fragen auf, wie wir sicherstellen können, dass KI-Systeme im Einklang mit menschlichen Werten und menschlicher Ethik handeln. Es geht nicht nur darum, KI zu lehren, „moralisch“ im menschlichen Sinne zu handeln, sondern vielmehr darum, eine präzise Übereinstimmung zwischen den Intentionen der Nutzer und den Aktionen der KI zu gewährleisten und zwar auch dann noch, wenn KI-Systeme in vielen Aspekten um Größenordnungen leistungsfähiger sein werden, als menschliche Intelligenz.

Die Lösung dieses Problems erfordert einen multidisziplinären Ansatz, der nicht nur Informatiker und Ingenieure, sondern auch Ethiker, Philosophen und Vertreter der breiten Öffentlichkeit einbezieht. Ich sehe hier auch eine wichtige Rolle für die skeptische Bewegung, denn kritisches Denken wird mehr denn je, zu einer Schlüsselkompetenz. Nicht zuletzt gehört die Förderung kritischen Denkens in einer breiten Öffentlichkeit zu unseren Satzungsgemäßen zielen. Wir sollten die Entwicklung von KI-Technologien nicht nur den Technologiegiganten überlassen, sondern einen breiten gesellschaftlichen Diskurs führen, um sicherzustellen, dass die KI der Zukunft im besten Interesse der Menschheit agiert.